| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- 다이나익 프로그래밍

- 패스트캠퍼스

- 백준 구간 합 구하기 5

- 백준 시그마 파이썬

- 모듈로 곱셈 역원

- 그리디알고리즘

- 백준 13172 파이썬

- AI강의

- 분할 정복

- 혁펜하임강의

- 백준 13172

- 혁펜하임AI

- 백준 Σ

- 백준 Σ 파이썬

- 큐

- 분할 정복을 이용한 거듭제곱

- 코딩테스트

- DP

- 백준 시그마

- 자료구조

- 혁펜하임

- AIDEEPDIVE

- 구현

- 다이나믹프로그래밍

- mysql

- 패스트캠퍼스혁펜하임

- 혁펜하임강의후기

- 수학

- 백준 구간 합 구하기 5 파이썬

- 알고리즘

- Today

- Total

MingyuPark

이진 분류와 다중 분류 - AI DEEP DIVE 후기 본문

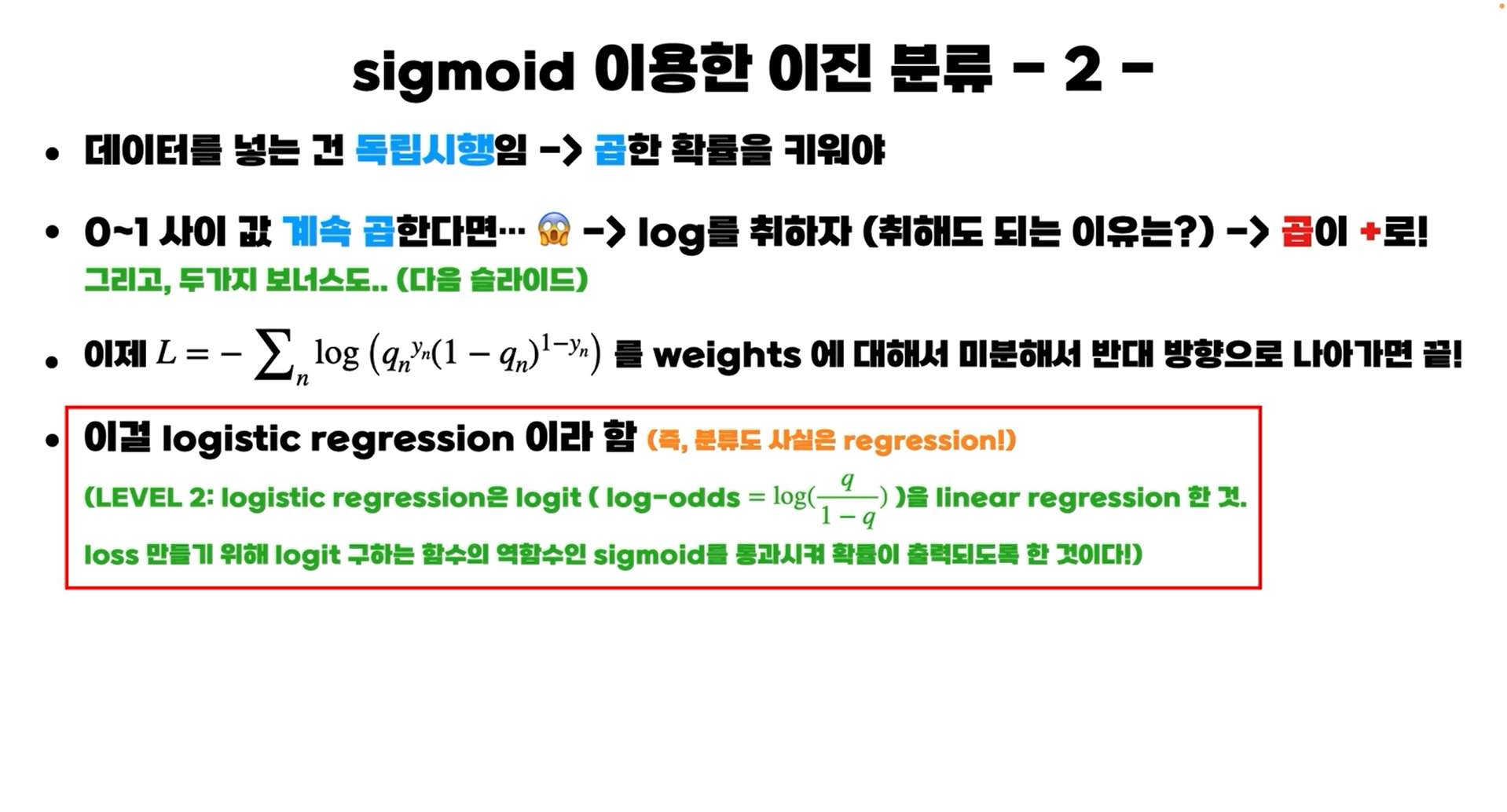

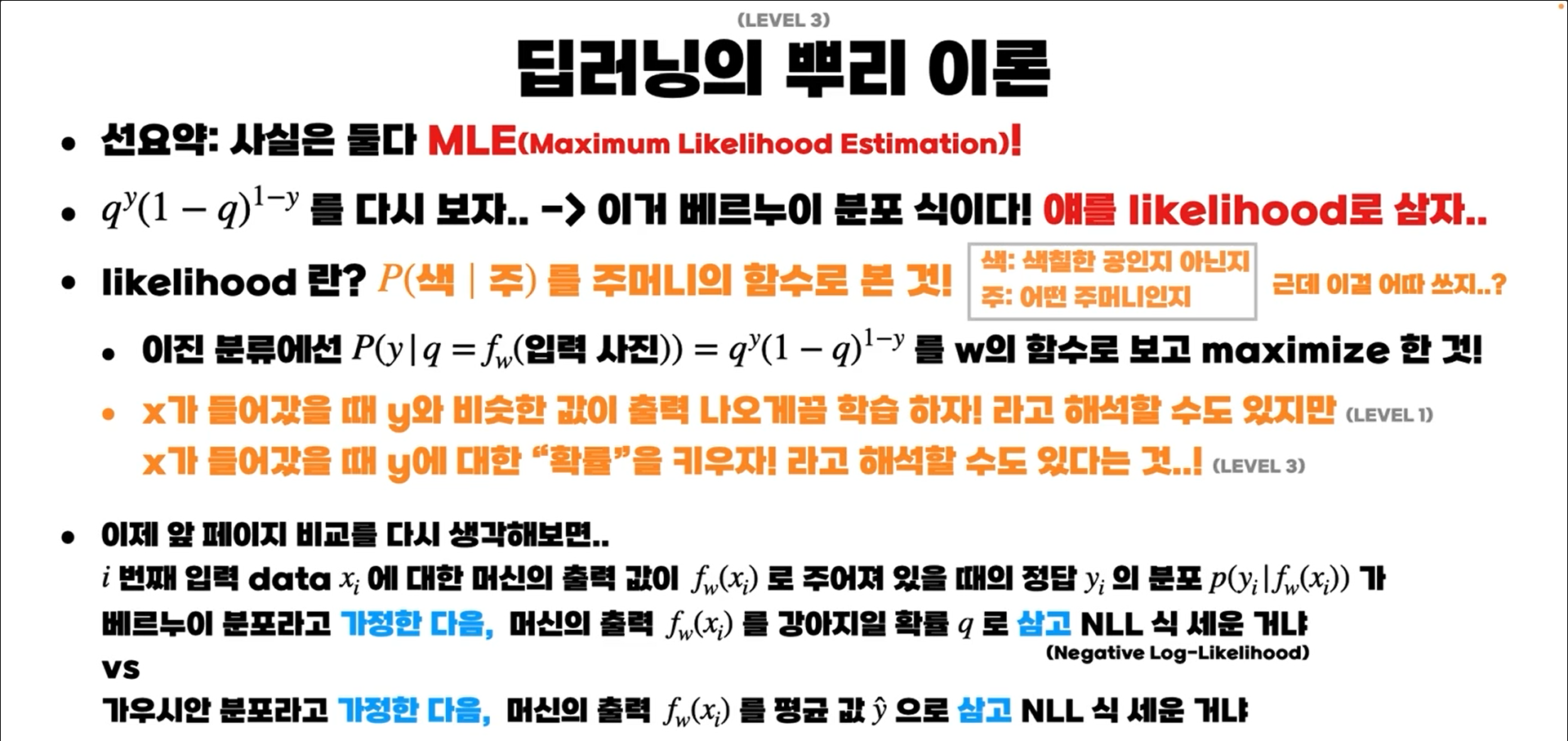

이번에는 강의 내용 정리보다는 Chapter 5. 이진 분류와 다중 분류. 의 학습 내용을 정리해보려고 한다.

주어진 사진에 대해서 그 사진이 강아지의 사진일 확률을 q라고 정의하면,

강아지면 q를 maximize, 고양이면 1-q를 maximize 하는 식으로 학습할 수 있다.

→ 한 번에 표현하면, qy(1−q)1−y를 maximize

각 데이터는 독립이기 때문에,

를 maximize 해야 한다.

n = 100인 상황을 고려해보자. $q_i^y_i (1-q_i)^{1-y_i}$가 0.9라도 이 값을 100번 곱하면 2.6561398887587544e-05로 거의 0에 가까운 값이 나온다. 이 문제를 해결하기 위해 log를 사용한다.

Σni=1logqyii(1−qi)1−yi=logqy11(1−q1)1−y1+logqy22(1−q2)1−y2+...+logqynn(1−qn)1−yn 를 maximize하면 된다.

여기에 (-)를 붙여서 Loss function을 정의하면, Loss function을 minimize하는 방향으로 학습을 진행하면 된다.

한 번 더 정리하면 다음과 같다.

L=−Σni=1logqyii(1−qi)1−yi

100개 중에 1개를 꺼내서 update하면 sgd, 전체를 쓰면 gd, 등등 이전에 설명했던 optimizer에 대해서 다시 정리해주셨다.

* Logistic regression ?

- logit에 대한 regression

- logit : 승산. q1−q로 계산한다. 즉, 위의 문제의 경우 (강아지사진일 확률[정답]) / (고양이일 확률[오답])

logq1−q=l→q1−q=el→1q−1=e−l→q=11+e−l

최종적으로 q=11+e−l 는 sigmoid와 동일해진다.

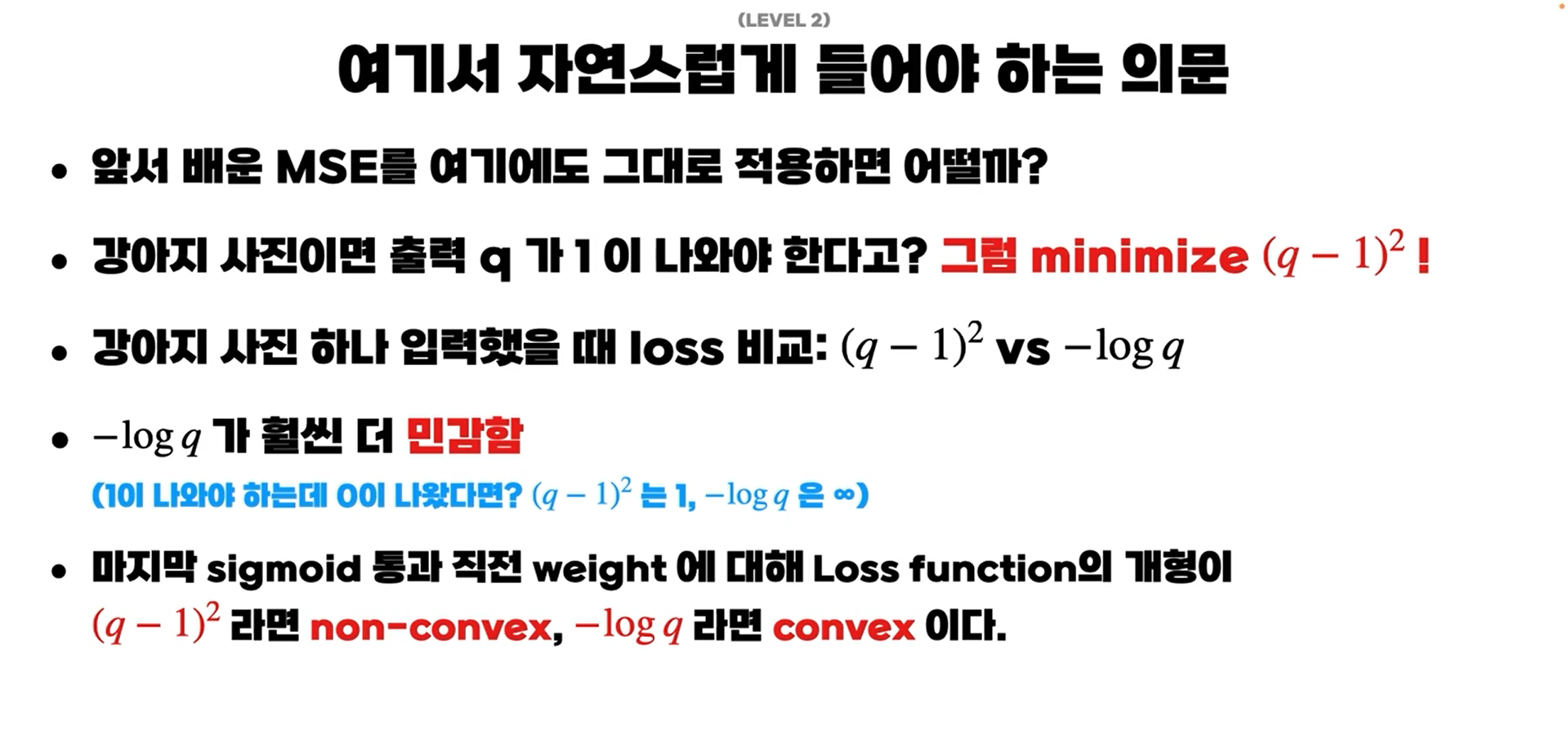

새로운 고민거리도 던져주셨다.

Loss function을 정의하는 것 자체가 잘못된 것은 아니지만, 아무 함수를 선택하면 그래프 개형이 달라지면서 계산이 더 복잡해지게 된다. 따라서 학습이 쉬워지고 어려워지는 등의 차이가 생긴다. 가 결론이다.

다음으로는, 앞선 두 loss function의 문제가 다음의 두 가지 상황에 대한 가정의 차이라고 생각할 수 있다.

xi 에 대한 출력값이 fw(xi)일 때, 정답 yi의 분포 p(yi|fw(xi))가

- 1. 베르누이 분포라고 가정한 후에 출력 fw(xi) 는 강아지일 확률 q라고 삼은 경우

- 2. 가우시안 분포라고 가정한 후에 출력 fw(xi) 는 평균값 ˆy로 삼은 경우.

- 본 게시글은 패스트캠퍼스 [혁펜하임의 AI DEEP DIVE] 체험단 활동을 위해 작성되었습니다.

- 링크 : https://bit.ly/3GV73FN

'Deep learning' 카테고리의 다른 글

| MLP, Backpropagation - AI DEEP DIVE 후기 (0) | 2023.02.06 |

|---|---|

| 가중치 초기화 / optimizer (0) | 2023.01.23 |